Это позволяет значительно сократить потребление памяти и ускорить процесс генерации.

Компания AMD анонсировала AMD-135M – свою первую компактную языковую модель, которая открывает новые возможности для эффективного использования искусственного интеллекта. AMD-135M применяет метод упреждающего декодирования, что в перспективе может существенно ускорить технологический прогресс.

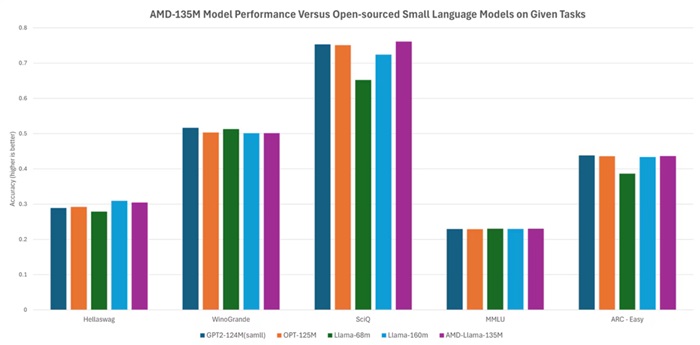

Эта модель, первая в семействе Llama, разработанном AMD, была обучена «с нуля» на базе ускорителей AMD Instinct MI250. В процессе обучения было использовано 670 млрд токенов. AMD-135M представлена в двух вариантах: AMD-Llama-135M для работы с общими данными и AMD-Llama-135M-code, специально дообученная для работы с кодом. Базовая модель AMD-Llama-135M обучалась в течение шести дней с использованием четырёх узлов MI250. Вариант AMD-Llama-135M-code прошёл дополнительное четырёхдневное обучение на 20 млрд токенов данных кода, используя то же оборудование.

Важно отметить, что AMD придерживается принципов открытости в сфере разработки ИИ. Код обучения, набор данных и веса модели AMD-135M имеют открытые исходники. Это позволяет другим разработчикам не только воспроизводить модель, но и использовать её для обучения других компактных и больших языковых моделей, способствуя более широкому и этичному развитию технологий искусственного интеллекта.

В последнее время большие языковые модели (LLM), такие как GPT-4 и Llama, привлекли значительное внимание благодаря своим впечатляющим возможностям в области обработки и генерации естественного языка. Однако компактные языковые модели (SLM), к которым относится и AMD-135M, становятся всё более важным инструментом в арсенале разработчиков ИИ. Они обладают рядом преимуществ, особенно в специализированных сценариях использования.

Традиционно большие языковые модели используют авторегрессивный подход для логического вывода. Однако этот подход имеет существенное ограничение: каждый прямой проход может генерировать только один токен, что снижает эффективность доступа к памяти и негативно влияет на общую скорость логического вывода.

Упреждающее декодирование, применяемое в AMD-135M, позволяет решить эту проблему. Суть метода заключается в использовании небольшой «черновой» модели для генерации набора токенов-кандидатов, которые затем проверяются более крупной целевой моделью. Такой подход позволяет каждому прямому проходу генерировать сразу несколько токенов без ущерба для производительности, что значительно сокращает потребление памяти и ускоряет процесс на несколько порядков.

Эффективность упреждающего декодирования была подтверждена тестированием. В качестве «черновой» модели для CodeLlama-7b использовалась AMD-Llama-135M-code. Тестирование проводилось как на ускорителе MI250 для центров обработки данных, так и на процессоре Ryzen AI (с NPU) для ПК с поддержкой ИИ. Результаты показали, что упреждающее декодирование обеспечивает заметное ускорение логического вывода на всех протестированных платформах AMD. Таким образом, AMD-135M формирует эффективный рабочий процесс, охватывающий как обучение, так и логический вывод, на базе современных платформ AMD.