Исследование показало, что ChatGPT потребляет в 10 раз меньше энергии, чем считалось ранее, но общий рост затрат на ИИ остаётся высокой проблемой

Исследователи из Epoch AI провели анализ энергопотребления ChatGPT и пришли к неожиданному выводу: модель тратит в 10 раз меньше электроэнергии, чем считалось ранее.

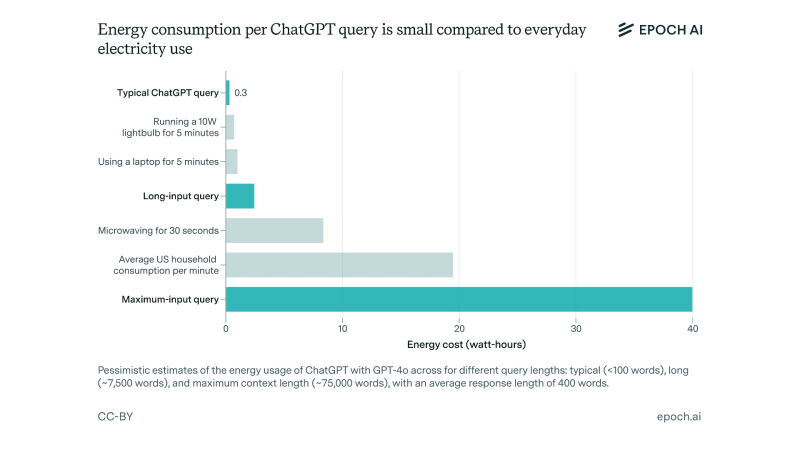

Ранее в СМИ часто звучала оценка: 3 Вт·ч на один запрос. Это примерно в 10 раз больше, чем поиск в Google. Однако новое исследование показывает, что всё не так страшно.

На самом деле средний запрос к ChatGPT (GPT-4o) потребляет около 0.3 Вт·ч, что сопоставимо с работой ноутбука за несколько минут.

Почему раньше назывались большие цифры?

Предыдущие оценки основывались на устаревших данных. Они предполагали, что OpenAI использует менее энергоэффективные чипы, а вычислительная инфраструктура остаётся неизменной.

Однако за последние годы технологии значительно продвинулись:

- Модели стали работать быстрее благодаря оптимизированным алгоритмам.

- Серверы используют энергоэффективные процессоры, что снижает нагрузку.

- Алгоритмы обработки запросов стали более точными, что сокращает избыточные вычисления.

В результате ChatGPT потребляет гораздо меньше энергии, чем ожидалось.

Но всё ли так хорошо?

Несмотря на рост эффективности, общие энергозатраты ИИ продолжают расти.

Согласно прогнозам Rand Corporation, к 2030 году обучение передовых ИИ-моделей может потреблять до 8 ГВт – это эквивалент работы восьми ядерных реакторов.

🔥 ИИ-модель s1, созданная за $50 и 26 минут, оказалась умнее ChatGPT в математикеtproger.ru

Кроме того, дата-центры, на которых работают нейросети, уже сейчас составляют значительную часть энергопотребления IT-индустрии.